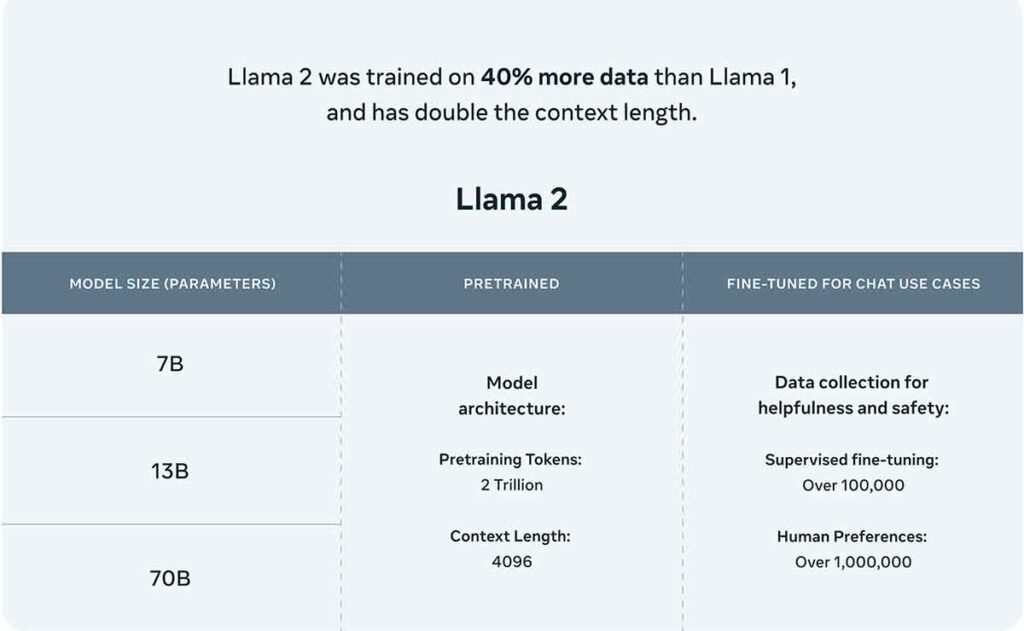

GenAI, Meta, ha lanzado Llama 2, una colección de modelos de lenguaje grande (LLMs) preentrenados y ajustados. Estos modelos, que varían en escala desde 7 mil millones hasta 70 mil millones de parámetros, están diseñados para superar a los modelos de chat de código abierto existentes en términos de utilidad y seguridad. Llama 2 y su variante, Llama 2-Chat, representan un avance significativo en la inteligencia artificial, ofreciendo un rendimiento mejorado y una mayor seguridad.

El Desarrollo de Llama 2 y Llama 2-Chat

Llama 2 es una familia de LLMs que han sido preentrenados y ajustados para optimizar su rendimiento. Los modelos Llama 2-Chat, una variante de Llama 2, están diseñados específicamente para casos de uso de diálogo, proporcionando una interacción más fluida y segura con los usuarios. Estos modelos superan a los modelos de código abierto existentes en la mayoría de los puntos de referencia de utilidad y seguridad que se probaron. Además, Llama 2-Chat muestra un rendimiento superior en términos de toxicidad y veracidad, lo que lo hace ideal para una amplia gama de aplicaciones.

Metodología de Preentrenamiento y Ajuste Fino

Para desarrollar Llama 2, GenAI implementó una serie de mejoras en el proceso de preentrenamiento, incluyendo una limpieza de datos más robusta, actualizaciones en la mezcla de datos y un aumento en la cantidad de tokens totales en los que se entrenó el modelo. Además, Llama 2-Chat se refinó a través de un proceso de ajuste fino supervisado y aprendizaje por refuerzo con retroalimentación humana. Este enfoque permitió a los modelos Llama 2-Chat superar a otros modelos en términos de utilidad y seguridad.

Asegurando la Seguridad del Modelo

La seguridad es una prioridad para GenAI, y se han tomado medidas para aumentar la seguridad de los modelos Llama 2. Esto incluye la anotación de datos específica de seguridad y el ajuste, así como la realización de pruebas de equipos rojos y la implementación de evaluaciones iterativas para garantizar la seguridad del modelo. Llama 2-Chat ha demostrado tener un porcentaje de violación general comparable o inferior en comparación con otros modelos, lo que refleja su robustez en términos de seguridad.

Comparación de Llama 2-Chat y ChatGPT

En comparación con ChatGPT, Llama 2-Chat ha demostrado ser competitivo, con una tasa de victoria del 36% y una tasa de empate del 31,5%. Aunque ChatGPT supera a Llama 2-Chat 70B en asistencia lingüística, Llama 2-Chat 70B supera al modelo de chat PaLM-bison en un gran porcentaje en nuestro conjunto de indicaciones. A pesar de las limitaciones de las evaluaciones humanas, nuestros resultados indican que Llama 2-Chat está a la par con ChatGPT en las evaluaciones humanas.

Tabla de comparación entre Llama 2-Chat y ChatGPT

| Modelo | TruthfulQA (↑) | ToxiGen (↓) | Win Rate (%) | Tie Rate (%) |

|---|---|---|---|---|

| Llama 2-Chat | 57.04 - 62.18 | 0.00 | 36 | 31.5 |

| ChatGPT | 78.46 | 0.20 | - | - |

Nota: Los valores de TruthfulQA y ToxiGen son más altos y más bajos respectivamente para un mejor rendimiento. Win Rate y Tie Rate se refieren a la comparación directa entre Llama 2-Chat y ChatGPT.