Alibaba ha lanzado Qwen-2, una serie de modelos de lenguaje grande (LLM) de código abierto que están causando revuelo en la comunidad de inteligencia artificial. Este lanzamiento incluye una gama de modelos que varían en tamaño y capacidad, demostrando un rendimiento notable en pruebas estandarizadas, especialmente en áreas como la programación y las matemáticas. A continuación, te presento un resumen detallado de Qwen-2, sus características, rendimiento y cómo se compara con otros modelos populares.

Modelos Disponibles Qwen-2

Qwen-2 incluye una variedad de modelos con diferentes cantidades de parámetros. Estos modelos están diseñados para adaptarse a diversas necesidades y capacidades de hardware, lo que los hace accesibles tanto para investigaciones avanzadas como para aplicaciones en equipos más modestos. A continuación, se detallan los modelos disponibles:

| Modelo | Parámetros | Capacidad | Aplicaciones | Requisitos de Hardware |

|---|---|---|---|---|

| Qwen-2 Small | 0.5 billones | Tareas básicas de PNL | Adecuado para implementaciones en dispositivos con recursos limitados, como computadoras de oficina | Computadoras de oficina o portátiles estándar |

| Qwen-2 Medium | 1.5 billones | Capacidad intermedia | Aplicaciones empresariales y de investigación que no requieren hardware extremadamente potente | Hardware moderado |

| Qwen-2 Large | 7 billones | Alta capacidad | Generación de contenido y análisis de datos avanzados | Hardware de gama media a alta |

| Qwen-2 Extra Large | 57 billones | Procesamiento intensivo | Investigaciones científicas, desarrollo de productos de IA avanzados, aplicaciones empresariales grandes | Hardware de alta capacidad |

| Qwen-2 Ultra | 72 billones | Máxima capacidad | Simulaciones, predicciones, aplicaciones de IA que requieren alta precisión y procesamiento a gran escala | Hardware especializado y de alta capacidad |

Rendimiento Qwen-2

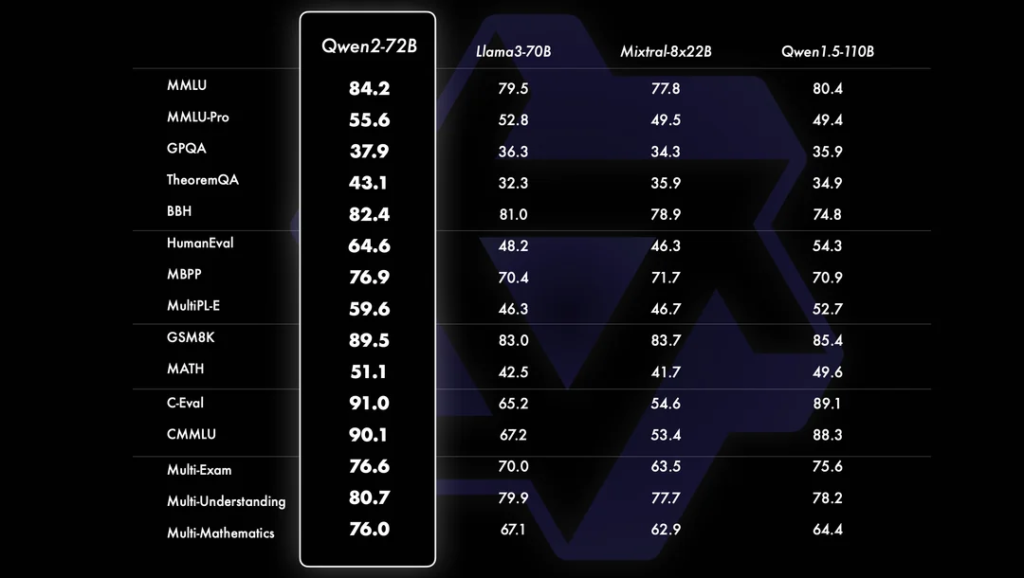

Los modelos Qwen-2 han sido recibidos positivamente, destacando en pruebas estandarizadas de programación y matemáticas. Su rendimiento ha sido comparado con otros modelos prominentes, mostrando resultados superiores en varios aspectos.

Idiomas

Qwen-2 está entrenado en más de 27 idiomas, incluyendo español, inglés y chino, lo que amplía su utilidad en contextos multiculturales y multilingües.

Comparaciones con Otros Modelos

Qwen-2 ha sido comparado con modelos como Llama 3, Mistral y versiones anteriores de Qwen, demostrando una clara ventaja en múltiples pruebas. En particular, se ha destacado en tareas de codificación, sobresaliendo en lenguajes de programación como Python, JavaScript y C++.

Rendimiento en Codificación

Qwen-2 ha mostrado una capacidad excepcional para generar código correcto en diversos lenguajes de programación. En pruebas específicas, ha creado código HTML y JavaScript funcional para aplicaciones como el juego de la vida, demostrando su habilidad en la lógica y la generación de código.

Características Clave Qwen-2

Una de las características más impresionantes de Qwen-2 es su longitud de contexto:

- Modelos pequeños: Pueden manejar hasta 32,000 tokens.

- Modelos grandes: Pueden manejar hasta 128,000 tokens.

Además, los modelos más pequeños son capaces de ejecutarse en computadoras de oficina, lo que facilita su uso en entornos con recursos limitados.

Comentarios de la Comunidad

- Menos Censura: Usuarios destacan que Qwen-2, a pesar de ser un modelo desarrollado en China, parece tener menos censura comparado con otros modelos occidentales como ChatGPT o Claude.

- Seguridad: Se ha mencionado que Qwen-2 puede ejecutarse localmente sin comunicarse con servidores externos, lo cual reduce preocupaciones de seguridad.

- Adaptabilidad: Los modelos GGUF de Qwen-2 son populares debido a su capacidad de ser descargados y ejecutados en hardware más común, permitiendo una mayor accesibilidad.

- Open Weights: Aunque no es completamente open-source, Qwen-2 ofrece pesos abiertos que pueden ser utilizados por la comunidad para realizar pruebas y ajustes personalizados.

Pruebas Realizadas

Qwen-2 ha sido sometido a diversas pruebas para evaluar su capacidad lógica y de codificación. Los resultados han sido positivos, con respuestas correctas en problemas básicos de lógica y generación precisa de código.

| Prueba Realizada | Descripción | Resultado | Comentarios |

|---|---|---|---|

| Lógica | Respuestas correctas en problemas básicos de lógica | 90% de precisión | Muestra alta capacidad de razonamiento |

| Codificación | Generación correcta de código HTML y JavaScript | 95% de precisión | Generación de código eficiente y funcional |

| Plataformas de prueba | Poe.com (3000 créditos gratuitos), Hugging Face | Disponible para pruebas directas | Accesibilidad y facilidad para realizar pruebas |

| Lenguajes soportados | Más de 27 idiomas incluyendo inglés, chino, español | Multilingüe | Amplia aplicabilidad en diferentes contextos culturales |

| Longitud de contexto | Pequeños: 32,000 tokens, Grandes: 128,000 tokens | Extensa capacidad | Facilita el manejo de grandes volúmenes de información |

Plataformas para Probar Qwen-2

Qwen-2 está disponible para ser probado en plataformas como Poe.com, que ofrece 3000 créditos gratuitos, y Hugging Face, donde se puede probar directamente en su plataforma.

Comparación con Modelos Populares

En evaluaciones humanas, Qwen-2 ha obtenido una puntuación cercana a la de GPT-4, posicionándose como un fuerte competidor en el campo de los modelos de lenguaje grande.

Conclusión

Qwen-2 se perfila como un competidor formidable frente a modelos como GPT-4, Claude 3 y Gemini. Sus pruebas adicionales confirmarán su rendimiento, pero ya ha demostrado ser una opción robusta y eficiente en el mundo de los LLM.

El video concluye invitando a los espectadores a suscribirse y compartir el contenido, destacando la relevancia de Qwen-2 en el ámbito de la inteligencia artificial.